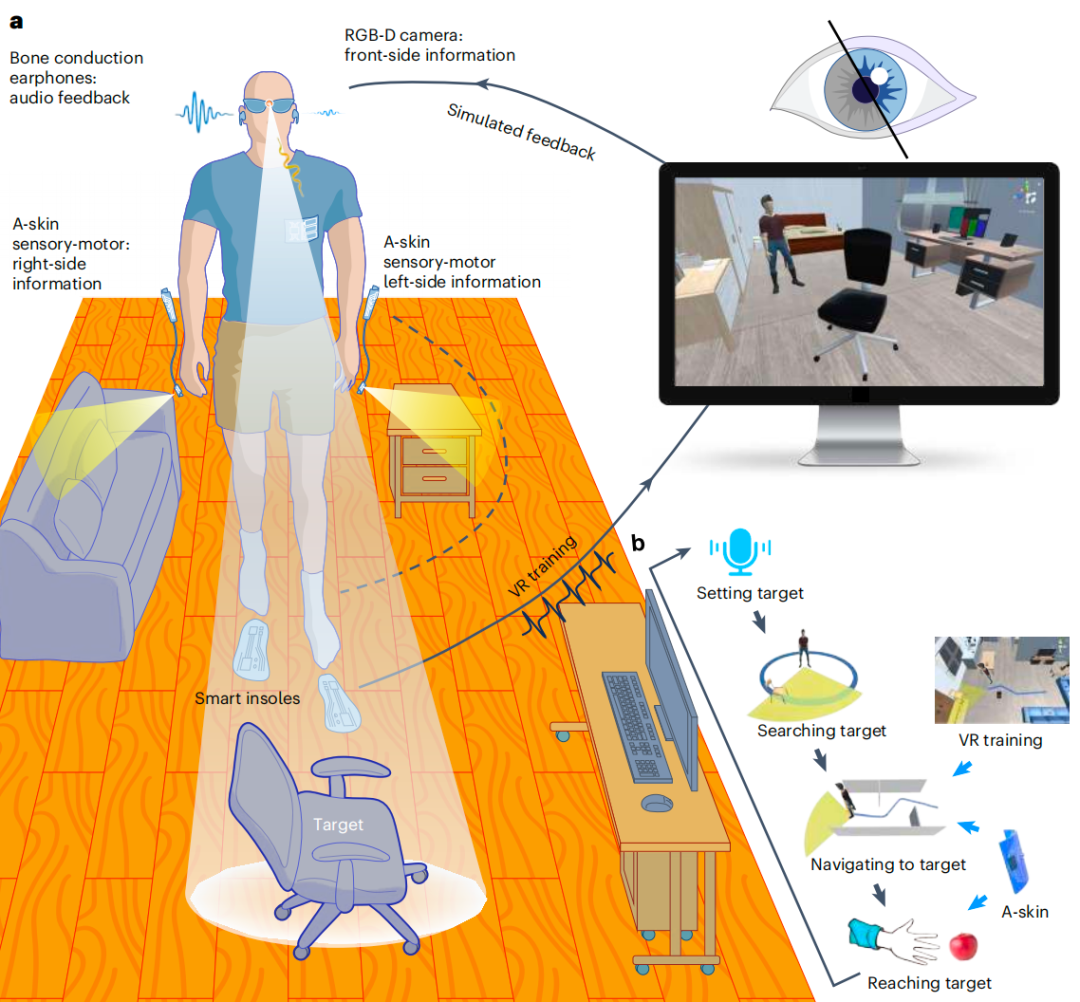

该研究开发了一款面向盲人和部分视力障碍者的可穿戴多模态视觉辅助系统,该系统利用人工智能(AI)解读安装在眼镜上的摄像头所拍摄的画面以勘测周围环境,在佩戴者接近障碍物或物体时会通过骨传导耳机进行语音提示,以及通过贴在手腕的可伸展“人造皮肤”进行震动提醒,指导佩戴者移动方向,避开两侧的物体,为其选择一条无障碍路线。

该研究提出了一种以人为本的多模态可穿戴系统,通过融合软件和硬件创新来提高可用性。该系统本质上是一副配有摄像头的智能眼镜,可以捕捉佩戴者周围环境的实时图像,该系统还通过一台微型计算机使用经过训练的机器学习算法来处理这些图像,从而检测周围环境中其他人以及门、墙和家具等物体的存在。该系统每250毫秒就会向用户提供关于周围环境的音频提示,并在左侧或右侧耳机上发出“哔哔”声,引导用户朝正确的方向前进。

研究团队还开发了一种灵活的可伸展“人造皮肤”贴片,可佩戴于手腕及手指区域实现导航增强。该装置集成视觉传感模块,当障碍物进入40cm至5cm临近区间时触发振动预警,并在用户执行抓取操作时提供触觉引导提示。

该设备通过自供电的摩擦起电智能鞋垫将真实用户与虚拟化身对齐,在精心设计的场景中支持有效的 VR 训练。

为了验证该系统的效果,研究团队招募了 20 名盲人或部分视力障碍者进行测试,在室内迷宫测试中,12 名参与者能够在室内迷宫中避开障碍物。在真实世界测试中,8 名参与者能够在城市街道上行走以及穿过摆满家具的会议室。

这些研究结果表明,整合视觉、听觉和触觉能增强视力辅助系统的可用性和功能性,为用户友好型视觉辅助系统铺平了道路,为改善视力障碍人士的生活质量提供了新的途径。

上海人工智能研究院领军科学家顾磊磊表示,目前该设备还处于原型机阶段,研究团队正在重点攻克系统稳定性和使用安全性等问题,以突破从实验室到实际应用的关键壁垒。