国际数据公司(IDC)近期就AR/VR产业发布了一份数据分析报告,其中AR头显装置在2023年全球的出货量为50万台,较2022年增长63.5%,并预测在2027年的出货量将达到680万台,2023-2027年复合增长率达96.5%。

但这些数据里的AR装置并不是AR眼镜“完全体”。

来源:IDC

2020年,Meta首席科学家迈克尔•亚伯拉什(Michael Abrash)通过媒体透露过,还需要5-10年时间才可能向市场推出“真正”的增强现实眼镜产品。其间,需要迭代数次,如优化音频、视频的输入,情境化的AI,等等。从已发布的产品及公开的信息看,Meta的AR眼镜也是按这个路径在推进的:

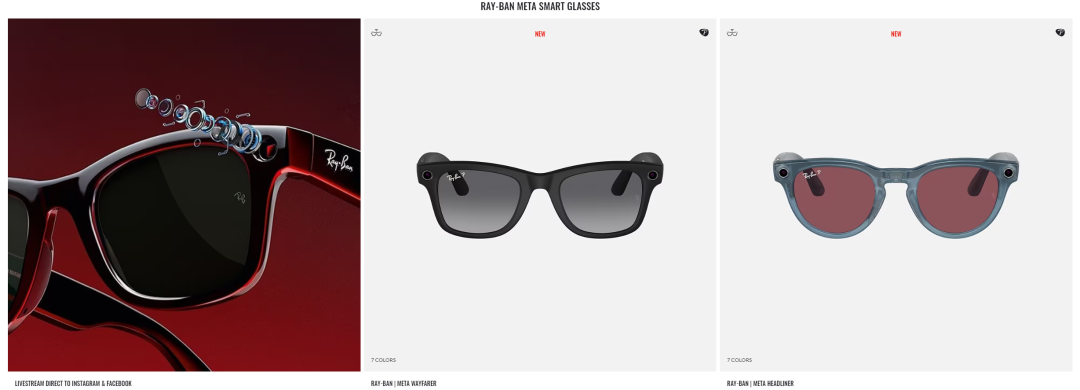

- 2021年9月初 Meta与雷朋(Ray-Ban)发布了第一代Ray-Ban Stories智能眼镜

- 2023年9月底,上述两家巨头又联合推出了第二代名为Ray-Ban Meta的智能眼镜

- 近日,Meta首席技术官安德鲁•博斯沃思(Andrew Bosworth)在采访中透露,Meta可能会在2024年展示一款代号为“Orion”的超前眼镜原型,但只供Meta内部小部分员工测试用

- 2027年,Meta计划推出第一款公开销售的AR眼镜“Artemis”

《Ray-Ban Stories(2021)智能眼镜》

来源:Meta官网

《Rab-Ban Meta(2023)智能眼镜》

来源:雷朋官网

相较于第一代,Meta与雷朋的第二代智能眼镜主要的升级项:

1)两颗摄像头从5MP升级到了12MP,可以录制1080P视频

2)麦克风由3颗变为5颗,拾音更清晰,并支持录制空间音频

3)扬声器音域更宽,实现了更好的低重音效果

4)可通过智能手机上的Meta View app直连Instagram与Facebook社交平台做直播

来源:FB官网

其实,其中最为亮眼的升级项是Meta在新一代的智能眼镜上集成了自家的Meta AI助手功能。

来源:Meta官网

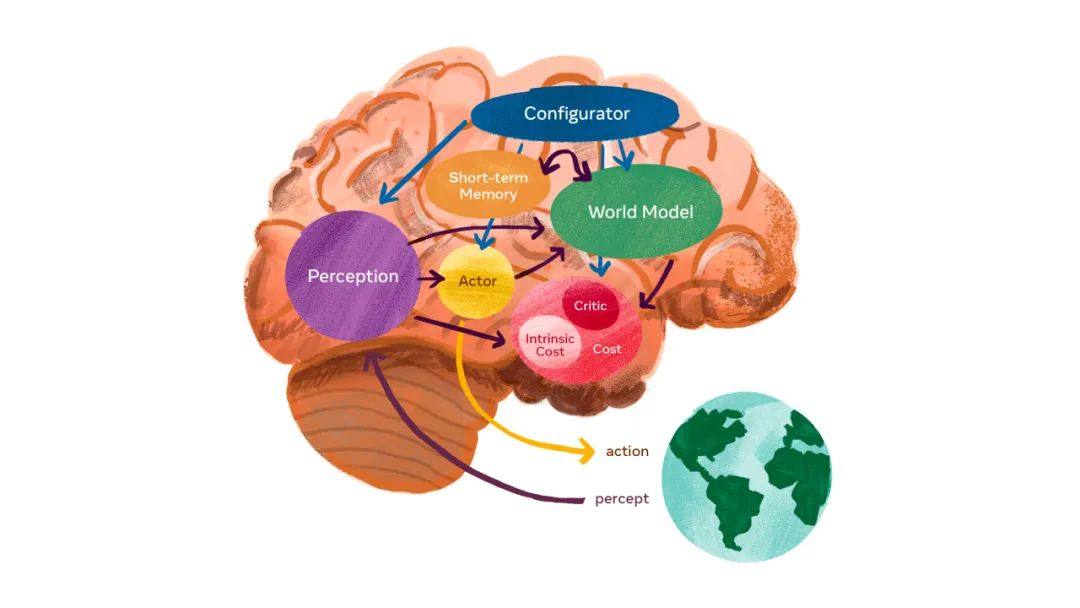

Meta AI助手不是传统的AI,而是多模态形式的AI,是“具身人工智能 (Embodied AI) ”,能以(如智能眼镜)使用者的视角,去观察和聆听外在世界,能够理解用户周围的环境,全天候支持且无需提示。

《自主智能系统构架》

来源:Meta官网

什么是“具身人工智能”(Embodied AI)?

传统AI利用计算机算力,通过算法分析数据,然后把所“学习到”的内容应用到新的情境中。AI赋能的计算机视觉系统在受控的环境中可以很好地工作,但在与真实世界互动时,距离、照明、方向等因素是持续变化的,传统的AI模式无法很好地匹配。此外,传统的AI路径很难做好对复杂运动的控制,也无法控制需要具有人类常识或约定俗成等因素的情境。因为这种常识根植于人类自身的形体的具化。“具身人工智能”(Embodied AI)便是把“具身”或者“体化”应用于人工智能系统的方法。

“具身人工智能”(Embodied AI)如何运行?

摒弃传统的严格以算法为主导的路径,人们先理解生物系统是如何运转的,然后开发出智能行为的总体原则,最后按此总体原则去建造智能设备。按此方法建造的智能设备配有各种传感器,智能设备利用AI与物理世界互动,通过传感器输入周边世界的数据,AI系统对数据做检查并通过数据进行“学习”。

简单总结一下:具身人工智能是基于具有感知能力的可移动载体(人体、机器人、汽车等)并实时与外界互动的人工智能形态,如特斯拉最近发布的第二代Optimus机器人。与之对应的是Internet AI,是通过喂数据训练出来的人工智能形态,如ChatGPT 4。

来源:Tesla

来源:Matrix AI

“具身人工智能”(Embodied AI)或许会在自动驾驶领域大放异彩,而在增强现实领域也大有可为,诸如Meta这样的头部公司早已在积极布局,并且在2023年实现了质的飞跃。Meta计划在2024年推出此AI功能。

时间回到2020年9月,Meta在其官方网站正式对外宣布启动了一个名为Aria的研究项目,此研究项目的目的是对可穿戴AR装置的未来做长期的研究,帮助Meta制造第一代可穿戴AR装置。

2023年10月,Meta的Aria项目团队正式公布了一份名为“Project Aria_A New Tool for Egocentric Multi-Modal AI Research”的白皮书,首次披露了多模态具身人工智能与AR眼镜相结合的诸多信息。

原文始发于微信公众号(舜宇奥来技术):微纳市场 | AR眼镜“完全体”应该是什么样的(上篇)